人工智能(AI)领域的不断发展与创新引领着世界进入了一个新的时代,而其中最具革命性的深度学习模型之一就是 Transformer。作为自然语言处理(NLP)和其他领域中的主要推动力之一,Transformer 模型通过其独特的结构和功能彻底改变了传统的序列建模方法。本文将全面介绍人工智能 Transformer 模型,包括其起源、原理、应用、对 AI 的影响以及未来发展趋势。

文章目录

Transformer 模型最初由 Google Brain 的研究团队在 2017 年提出,其首次应用于机器翻译任务中,取得了惊人的成果。与传统的循环神经网络(RNN)和长短期记忆网络(LSTM)相比,Transformer 模型具有更好的并行性和更短的训练时间,使其在处理长距离依赖关系时表现更为出色。

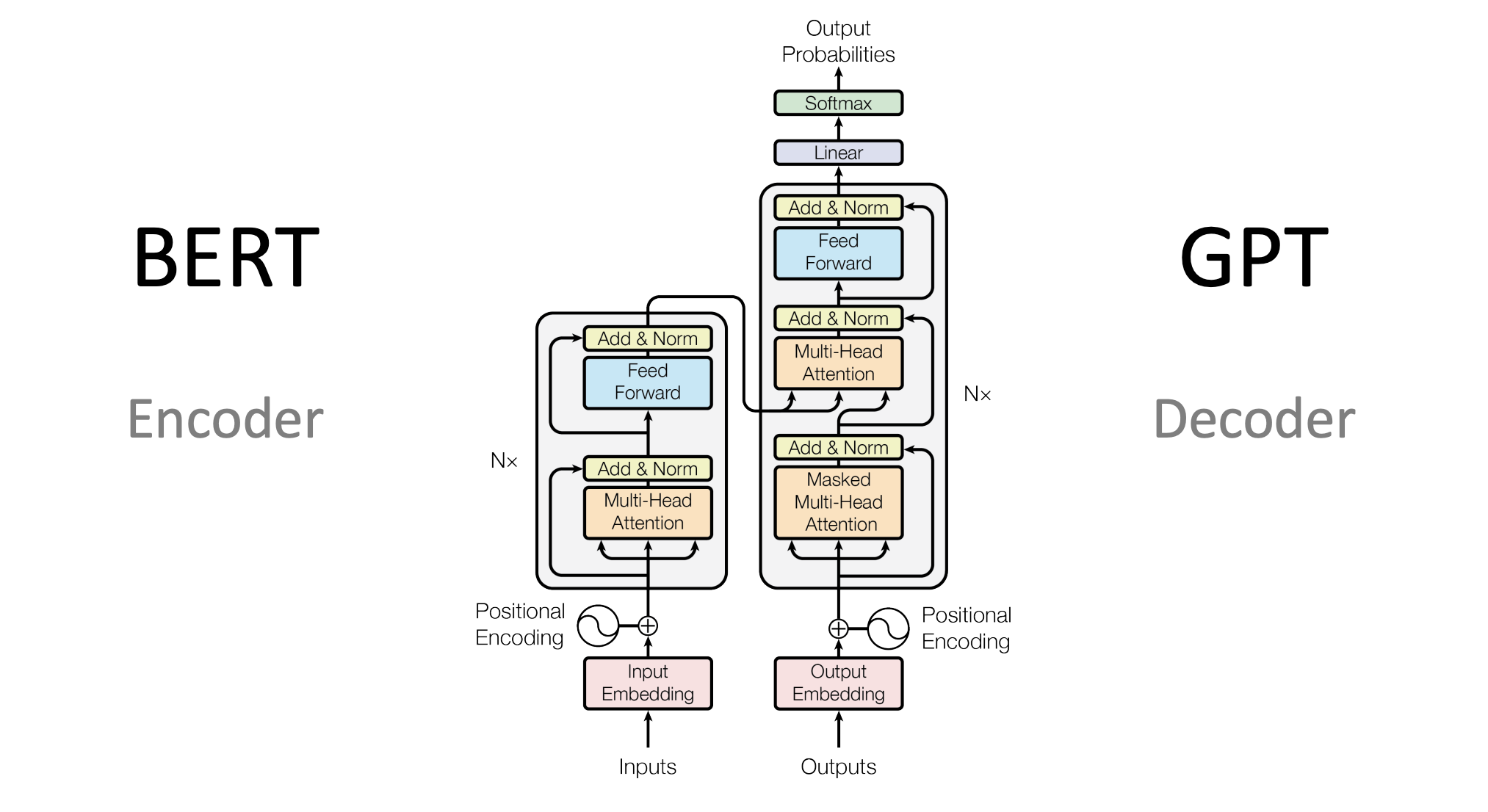

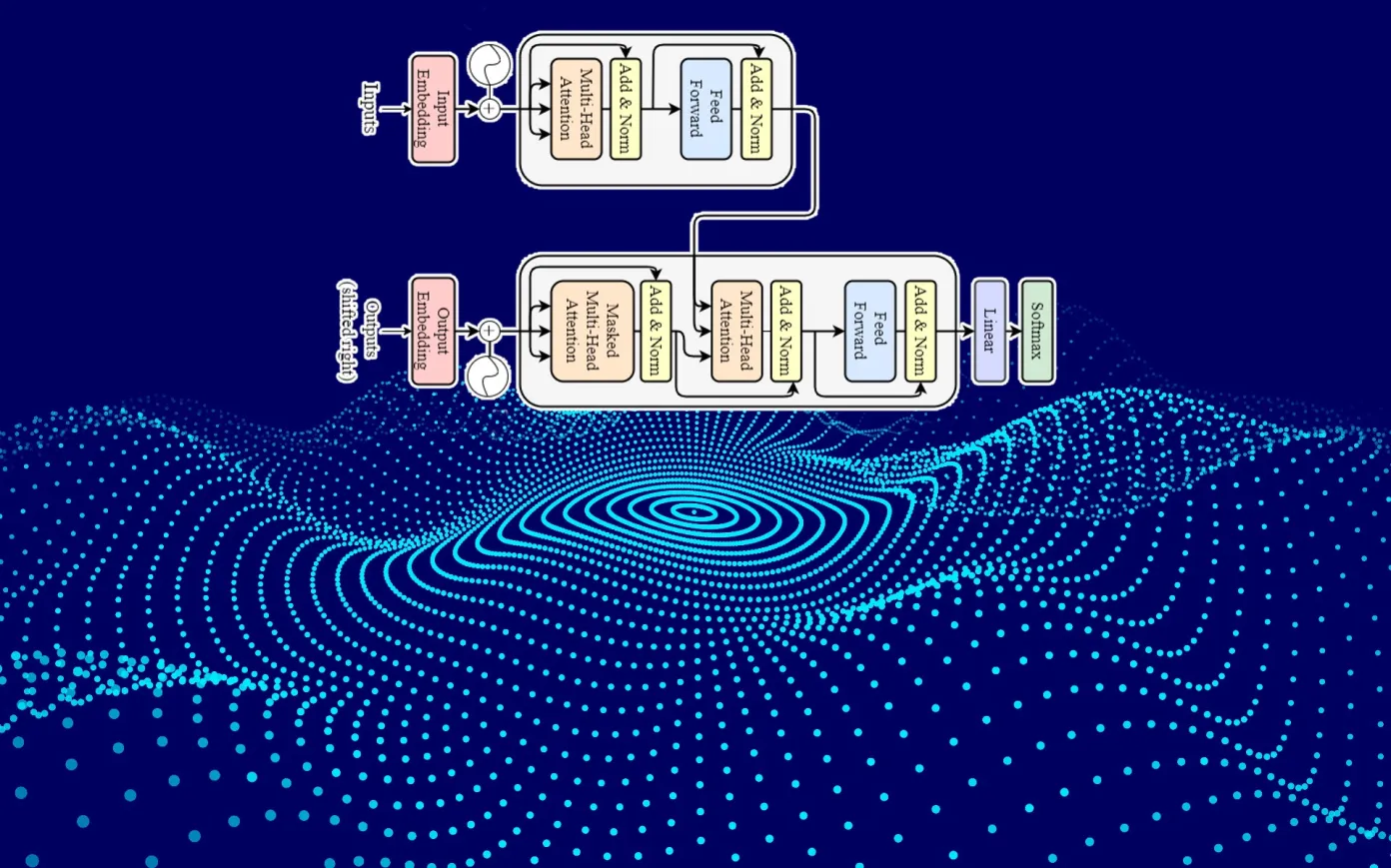

Transformer 模型的核心是由多层自注意力和前馈神经网络组成的编码器和解码器结构。编码器用于将输入序列编码成连续的表示,而解码器则将编码后的表示解码成目标序列。自注意力机制允许模型在不同位置之间动态地分配注意力权重,从而更好地理解序列中的上下文信息。

Transformer 模型在自然语言处理领域有着广泛的应用,包括机器翻译、文本摘要、情感分析、命名实体识别等任务。此外,Transformer 模型还被应用于计算机视觉、语音识别等领域,并取得了令人瞩目的成果。

Transformer 模型的出现对人工智能领域产生了深远的影响。首先,它推动了自然语言处理领域的发展,使得诸如 BERT、GPT 等预训练模型成为可能,进一步提升了文本理解和生成的能力。其次,Transformer 模型的成功也启示了人们对于模型结构的创新和优化,推动了深度学习领域的进步。

Transformer 广泛应用于自然语言处理任务中,如文本生成、文本分类、机器翻译等。例如万兴播爆的智能脚本生成的发展即离不开 Transformer 模型。Transformer 模型在自然语言处理任务中具有出色的语言理解和生成能力,可用于构建数字人智能脚本的语言模型,使其能够理解和生成自然语言。

随着时间的推移,人工智能 Transformer 模型正在不断演进和发展。研究人员正在探索更加高效的模型结构和训练方法,以进一步提升模型的性能和泛化能力。同时,Transformer 模型也在不断应用于新的领域,如推荐系统、图像生成等,为人工智能技术的发展开辟了新的方向。

人工智能 Transformer 模型作为深度学习领域的重要成果之一,以其独特的结构和功能影响着整个人工智能领域的发展。通过不断的创新和探索,Transformer 模型将继续推动人工智能技术向着更加高效、智能的方向发展,为人类社会带来更多的创新和进步。