在自然语言处理(NLP)领域中,Transformer模型已经成为了一种非常流行和有效的模型架构。它在各种任务中取得了令人瞩目的成果,例如文本生成、文本分类、机器翻译等。本文将就Transformer模型的优点和缺点展开探讨。

1、并行性高

Transformer模型的编码器和解码器具有高度并行的特性,可以同时处理多个输入或输出序列。这种并行性带来了显著的训练和推断速度提升,特别适用于应对大规模数据的处理需求。与传统的循环神经网络(RNN)相比,AI Transformer模型的并行性使其能够更高效地利用计算资源,从而实现更快的训练和推断过程。

2、远距离依赖性

传统的循环神经网络(RNN)在处理长距离依赖性时往往会遇到梯度消失或梯度爆炸的问题,限制了其在捕捉长距离依赖关系方面的表现。而Transformer模型通过引入注意力机制,能够轻松地捕捉到远距离的依赖关系,从而显著提高了模型的性能。这种机制使得Transformer模型能够更好地理解输入序列中各个位置之间的关联,从而提升了其在各种任务中的表现。

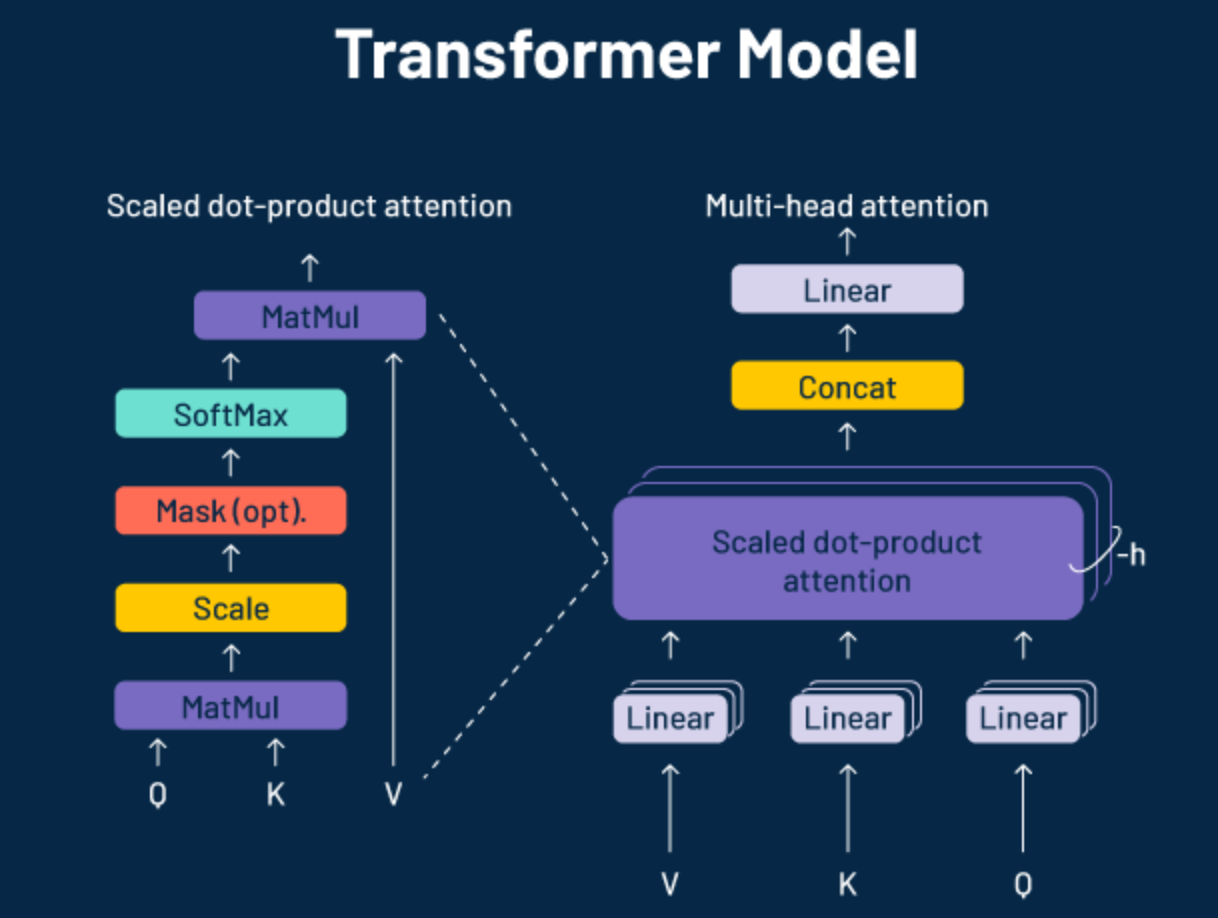

3、多头注意力机制

Transformer模型引入了多头注意力机制,允许模型在不同的注意力头中学习到数据的不同表示。这有助于模型更好地理解输入序列的不同方面,从而提高了模型的表现力。

4、适应性强

Transformer神经网络在各种NLP任务中都表现出色,不仅适用于传统的序列到序列任务,还能应用于文本分类、命名实体识别、问答系统等多个领域,展现了其广泛的适应性。

5、长序列处理能力

Transformer通过自注意力机制实现了对长序列的处理,与传统的循环神经网络相比,Transformer不会出现梯度消失或梯度爆炸的问题,使得其更适用于处理长序列数据。

1、计算资源消耗大

Transformer通常需要大量的计算资源进行训练和推理,尤其是在处理大规模数据时。这使得Transformer在资源受限的环境下难以应用。

2、数据量需求高

Transformer通常需要大量的标注数据进行训练,尤其是在应用于特定领域时。如果数据量不足,模型可能会出现过拟合的问题。

3、可解释性差

Transformer的复杂性使得其内部的决策过程较难解释。相比于传统的线性模型或树形模型,Transformer的黑盒特性使得其在一些应用场景下难以被理解和接受。

4、对序列顺序敏感

Transformer虽然在处理长距离依赖性时表现出色,但在处理一些需要考虑序列顺序的任务时可能会存在一定的挑战,例如时间序列预测等。

5、模型大小

Transformer通常需要大量的参数才能达到较好的性能,导致模型的体积较大,不利于在资源受限的设备上部署和应用。

万兴的"天幕",以音视频生成式AI技术为核心,综合创作大模型,包括视频、音频、图片、语言等领域,专注于数字创意。汇聚二十年数字创意产品开发运营经验,具备多媒体处理、垂直解决方案、算力数据等特色,支持全球内容创作者的创意表达。旗下AIGC数字人视频创作软件——万兴播爆。

Transformer作为一种强大的NLP模型,在处理长距离依赖性和多种NLP任务方面表现出色,但同时也面临着计算资源消耗大、数据量需求高、可解释性差等挑战。随着技术的不断发展和改进,相信Transformer模型在未来会进一步完善和应用于各种实际场景中。