自然语言处理(NLP)是人工智能领域中的一个重要分支,旨在使计算机能够理解、处理和生成人类语言。NLP 大模型是近年来随着深度学习技术的发展而崭露头角的一类重要技术。这些模型利用深度神经网络和大规模语料库,能够在各种自然语言处理任务上取得前所未有的性能。

NLP 大模型的基本原理是利用深度神经网络对大规模文本数据进行训练,以学习语言的表示和语言规律。这些模型通常采用 Transformer 架构,其中包括多层的自注意力机制,能够有效地捕捉文本中的长程依赖关系。通过预训练和微调的方式,这些模型能够适应各种不同的自然语言处理任务。

1、语言建模

NLP 大模型可以用于语言建模,即根据给定的文本序列预测下一个单词或字符的概率分布。这种技术在机器翻译、语音识别和语言生成等任务中都有重要应用。

2、文本分类

NLP 大模型可以用于文本分类任务,如情感分析、垃圾邮件检测和新闻分类等。通过将文本序列映射到固定长度的向量表示,这些模型能够有效地捕捉文本的语义信息,并用于分类任务。

3、问答系统

NLP 大模型可以用于问答系统,如阅读理解和智能客服。通过对问题和文本段落进行编码,这些模型能够准确地定位并提取文本中的相关信息,从而回答用户的问题。

4、文本生成

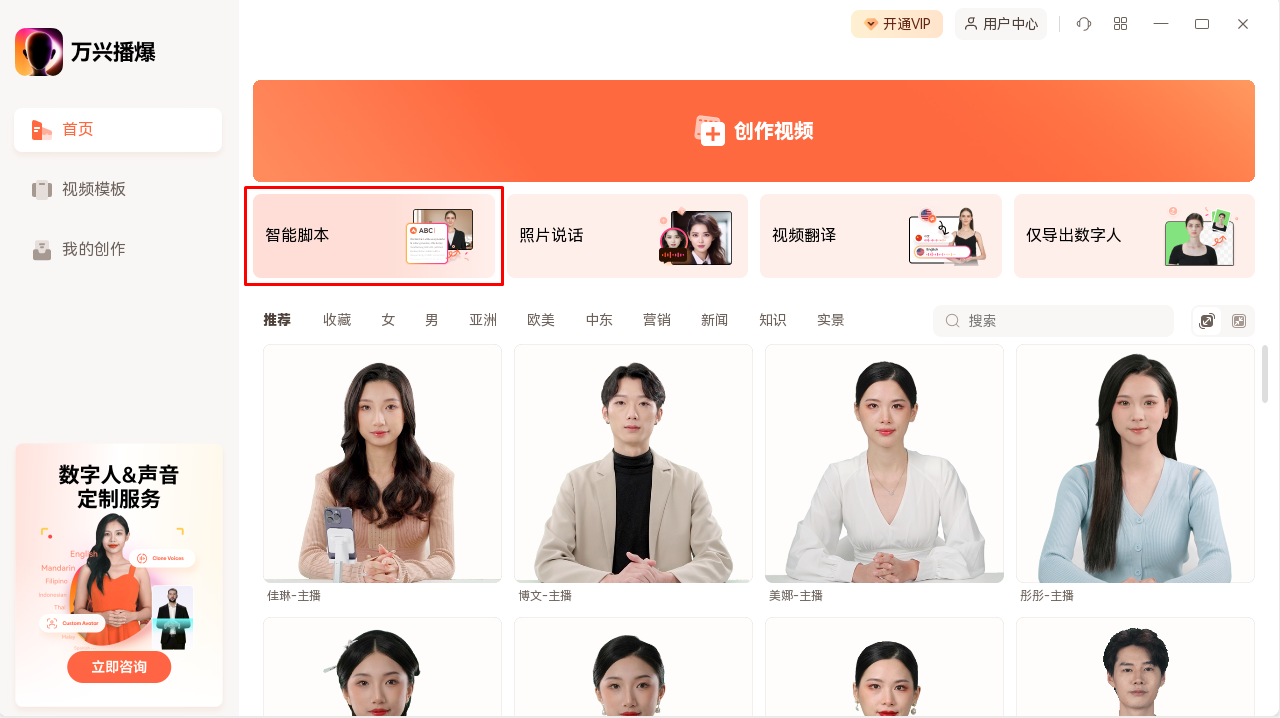

NLP 大模型可以用于文本生成任务,包括机器翻译、对话生成和文章摘要等。这些模型通过学习文本序列的概率分布,能够生成与输入文本相关的新文本,具有广泛的应用前景。例如,万兴播爆的AI智能脚本就是利用了这一技术,能够自动生成视频脚本,为视频制作过程提供了便利和灵感。

近年来,随着计算能力的快速提升和数据规模的不断扩大,自然语言处理(NLP)领域的大型预训练模型取得了巨大的发展。这些模型利用深度学习技术和海量的文本数据,在各种 NLP 任务上取得了突破性的成果。

其中,BERT(Bidirectional Encoder Representations from Transformers)是一种革命性的预训练语言模型,由Google提出。BERT通过双向编码器架构,结合大规模语料的无监督预训练和有监督微调,在包括文本分类、问答系统和命名实体识别等多个任务上实现了state-of-the-art的表现。

另一个重要的模型是GPT(Generative Pre-trained Transformer),由OpenAI推出。GPT采用了单向的transformer神经网络解码器结构,在语言建模和文本生成任务中表现出色。其能够生成连贯、富有语义的文本,被广泛应用于对话系统、文章摘要等领域。

此外,XLNet是另一个备受关注的模型,由谷歌提出。XLNet结合了BERT和自回归模型的优点,通过双向上下文建模和自回归预训练相结合,取得了在多项任务上超越BERT的成绩,尤其在语言建模和序列分类任务上表现出色。

NLP 大模型是近年来自然语言处理领域的重要进展之一,具有广泛的应用前景。通过利用深度学习技术和大规模语料库,这些模型能够在各种自然语言处理任务上取得前所未有的性能,为实现人机交互和智能化应用提供了强大的工具和支持。随着技术的不断进步和应用场景的不断拓展,相信 NLP 大模型将在未来发挥越来越重要的作用。